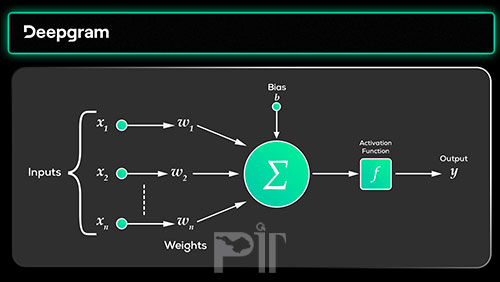

در شبکه های عصبی کدام تابع های فعال سازی (Activation Functions ) را برای کدام الگوریتم استفاده کنیم؟

برای شبکه های CNN و MLP معمولا تابع ReLU استفاده می شود.

برای شبکه های RNN معمولا توابع Sigmoid و tanh استفاده می شوند.

تابع ReLU یک تابع جنرال نیز وجود دارد که برای اکثر شبکه های عصبی می تواند استفاده بشود.

توجه: در مواردی که ذکر شد قانون خاصی وجود ندارد، شما می توانید همه ی توابع فعالسازی غیر خطی مخصوص hidden layers رو می توانید استفاده کنید، مهم این است که به بهترین عملکرد الگوریتم خودتان برسید.

نکته:

توابع فعال سازی برای Output layer:

Linear

Sigmoid

Softmax

توابع فعال سازی برای Hidden layer:

ReLU

Sigmoid

tanh